| Rozkład normalny to podstawowy rozkład w statystyce. Mówimy, że taka-to-a-taka cecha ma rozkład normalny. Że założenia testów różnych testów statystycznych: testu t-Studenta oraz analizy wariancji ANOVA wymagają rozkładu normalnego. Że model jest dobry, gdy rozkład błędów jest normalny. Skąd jednak badacz ma wiedzieć, czy zebrane przez niego liczbowe wartości zmiennej układają się zgodnie z krzywą Gaussa? W tym poście piszę, jak należy sprawdzać, czy cecha w zebranej przez Ciebie próbie może mieć rozkład zbliżony do normalnego. Jeśli chcesz przejść od razu do narzędzi, kliknij tutaj: KLIK. |

WPROWADZENIE — W każdej dziedzinie jest zbiór pojęć rozpoznawanych poza nią. W psychologii jest to np. procesy poznawcze. W statystyce takim pojęciem funkcjonującym w zbiorowej świadomości jest rozkład normalny łatwo zapamiętywalny ze względu na charakterystyczny, dzwonowaty kształt. Wiele lat temu uważano, że rozkład normalny stanowił dobry model zjawisk społecznych. Obecnie odchodzi się od tego myślenia, ale nie zmienia to jego popularności, zwłaszcza że analizy, jakie wykorzystują badacze, opierają się na tym rozkładzie. Więcej informacji na temat rozkładu normalnego znajdziesz w poście KLIK. Tutaj ograniczymy się do tylko części potrzebnej do zrozumienia, jak działają narzędzia diagnostyczne służące do - jak sama wskazuje - diagnozy tego, czy badana cecha ma rozkład normalny. Takie zadanie często stoi przed badaczem i najprawdopodobniej szukałby on jakiegoś testu statystycznego. Wiadmo, jak statystyka, to testy. Badacze mają nawyk testowania wszystkiego w dobrym i złym tego słowa znaczeniu, więc nic dziwnego, że jako pierwsze przychodzą do głowy testy statystyczne. Istnieją jednak inne nie-testowe metody oceny normalności rozkładu — i o tym jest ten post.

DIAGNOSTYKA NORMALNOŚCI A TYP POMIARU — Narzędzia służące do oceny normalności rozkładu stosujemy tylko i wyłącznie wtedy, gdy wiemy, że mierzona przez nas zmienna czy badana cecha ma najwyższy w skali Stevensa, ilościowy typ pomiaru, np. jest to czas reakcji, wiek, długość, szerokość. Często przyjmuje się, że wyniki ogólne w kwestionariuszach również charakteryzują się tym typem pomiaru. Chodzi o to, że narzędzia, jakie zaraz poznasz, działają dla tych zmiennych, których wartości reprezentują matematycznie rozumiane liczby. Liczby, które można dodawać, mnożyć, dzielić, a nie "liczby" ujęte w cudzysłów, bardziej znaki graficzne, jak dla zmiennej nominalnej albo porządek jak dla zmiennej porządkowej. Rozkład normalny mogą posiadać jedynie zmienne ilościowe. Nie badamy normalności dla płci (kobieta, mężczyzna, niebinarna) czy wykształcenia (mierzonego kategoriami: podstawowe, średnie, wyższe)

CZY ISTNIEJE JEDEN ROZKŁAD NORMALNY? Patrząc na powyższy rysunek, widzimy tylko jeden z możliwych rozkładów normalnych. Taki, który ma parametry 0 i 1. Kreskowaną linią zaznaczono szczyt tej krzywej, który jednocześnie jest średnią. Ponieważ zamiast zera i jedynki może stać tutaj absolutnie dowolna liczba rzeczywista, to rozkładów, o których można powiedzieć, że są normalne, jest nieskończenie wiele. Dlaczego jest ich nieskończenie wiele, a jakby jeden? Wszystkie łączy ten sam wzór ogólny. Posiadając wspólną matematyczną formułę, tworzą jedną rodzinę. Jedyne, co się w niej zmienia, to drobiazgi zwane parametrami - to co na rysunku jest zerem i jedynką. Ogólny wzór pozwala narysować krzywą Gaussa przypominającą dzwon (choć czasem trudno go zobaczyć).

Na podobnej zasadzie działa funkcja liniowa np. y = x + 2 lub y = -x - 1.

W każdym wzorze zamiast jedynek i dwójek mogłaby stać dowolna inna liczba, a i tak nadal byłaby to funkcja liniowa z wykresem w postaci linii prostej. Wszystkie spełniają tzw. ogólny wzór postaci: y = a*x+b. Podobnie, rozkłady normalne mają jeden wspólny wzór, choć nieco bardziej skomplikowany niż ten na funkcję liniową. Widzisz go w górnym lewym rogu poniższej ilustracji:

Rozkład, którego rysunek widzisz, jest jednym z wielu rozkładów normalnych, ale jest to charakterystyczny członek tej rodziny - tzw. rozkład standardowy normalny N(0,1), gdzie zero to pierwszy parametr zwany średnią, a jeden to drugi parametr zwany odchyleniem standardowym.

Wspólny wzór powoduje, że mimo różnic w wyglądzie, członkowie rodziny rozkładów normalnych dzielą podobne własności i to właśnie wykorzystują narzędzia diagnostyczne. Rozsądne byłoby pomyśleć tak: jeśli oczekujemy, aby badana cecha (lub szerzej - zmienna) miała rozkład normalny, to powinna się w rozsądnym stopniu wykazywać tymi właściwościami.

Na przykład, jeśli chcesz sprawdzić, czy masz do czynienia z psem, to sprawdzasz, czy dany obiekt szczeka, ma ogon i chodzi na czterech łapach (lub w odwrotnej kolejności). Wszystkie nieuszkodzone psy mają te właściwości.

NARZĘDZIA DIAGNOSTYCZNE — Narzędzia diagnostyczne dzielą się na liczbowe i na graficzne. Te pierwsze po prostu liczby, a profesjonalnie rzecz mówiąc: statystyki opisowe. Te drugie to wykresy. O ile wskazanie teoretycznych wartości statystyk liczbowych nie jest trudne, problemem staje się to, jak pokazać działanie empirycznych narzędzi na teoretycznym tworze, jakim jest rozkład normalny. Poradzimy sobie, stosując mały trik. Skoro przyjmuje się, że rozkład teoretyczny jakieś cechy to rozkład w całej populacji, to weźmiemy przeogromną próbę i na takiej zbadamy zachowanie narzędzi. W ten sposób będziemy mogli zbliżyć się do teoretycznego rozkładu normalnego i jednocześnie poznać narzędzia diagnostyczne.

Oto lista narzędzi wraz z omówieniem ich zachowania wśród rozkładów teoretycznych (niżej jest lista z omówieniem zachowania w próbie)

- STATYSTYKI OPISOWE

- skośność - miara asymetrii rozkładu. Rozkład normalny ma zerową skośność. Więcej na ten temat znajdziesz w poście: KLIK

- kurtoza - miara koncentracji i obecności obserwacji odstających. Rozkład normalny ma zerową kurtozę. Więcej na ten temat znajdziesz w poście: KLIK

- WYKRESY

- histogram — wykres pokazujący ogólny kształt rozkładu poprzez zestaw prostokątów, których szerokość to przedział liczbowy, a wysokość to liczba obserwacji, które znalazły się w tym przedziale. Więcej o histogramie: KLIK. Mimo tego, że rozkładu teoretycznego nie przedstawia się za pomocą histogramu, a za pomocą gładkiej linii reprezentującą gęstość lub kropek reprezentujących funkcję prawdopodobieństwa (mówimy o teoretycznych sprawach), to przeogromna próba będzie substytutem populacji. Powinna się wpasowywać w krzywą Gaussa.

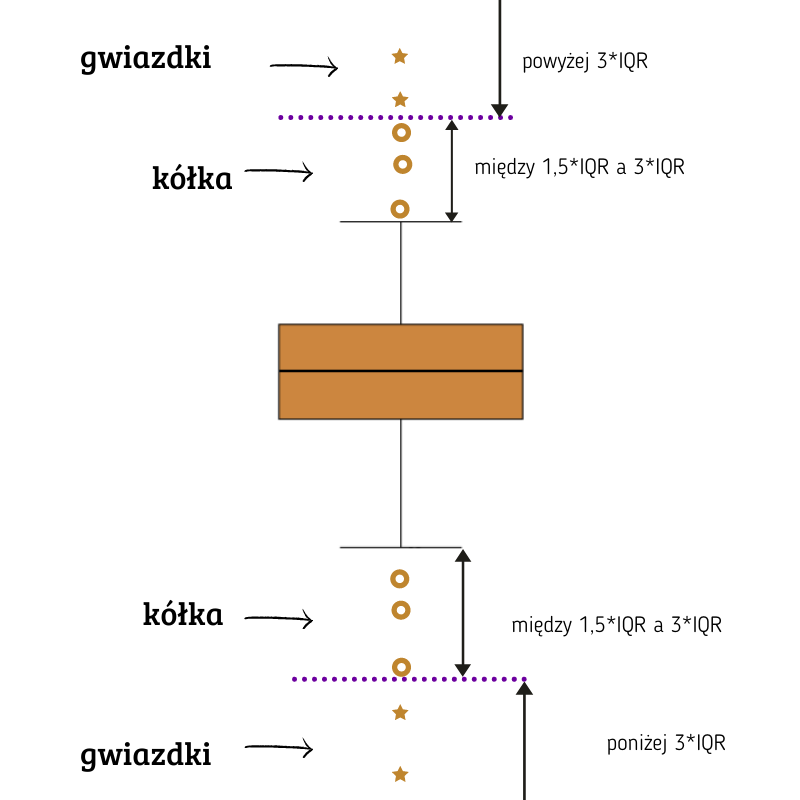

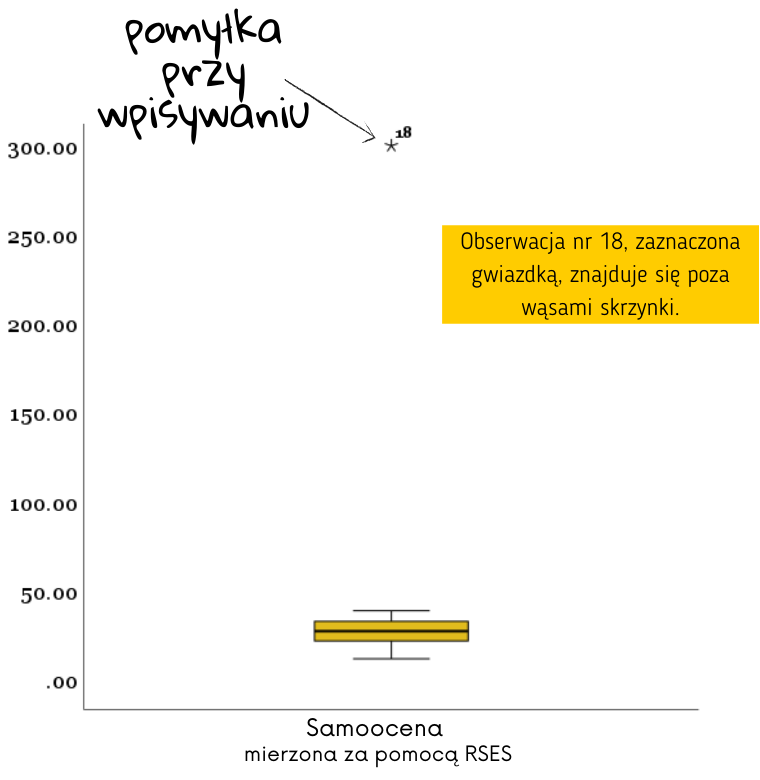

- wykres skrzynkowy (boksplot) - wykres, pokazujący jeden prostokąt z wąsami. Rozkład normalny tworzy wykres postaci:

Jest on symetryczny względem czarnej poziomej linii reprezentującej medianę. Wąsy są w równej odległości od dolnej i górnej krawędzi skrzynki. Rozkład normalny posiada też obserwacje odstające (outliery) - a to ze względu na regułę 3 sigma. Więcej o boxplocie: KLIK

- wykres kwantylowy — wykres przestawiający punkty. Na osiach znajdują się kwantyle rozkładu badanej cechy oraz kwantyle rozkładu normalnego. Więcej o wykresie kwantylowym: KLIK

ZACHOWANIE NARZĘDZI W PRÓBIE — Przeanalizujemy teraz każde z narzędzi i omówimy jego zachowanie w próbie. Przechodząc z teorii do empirii, należy pamiętać, że są dwie rzeczy, które mają wpływ na to, że najczęściej jedno z drugim nie zgadza się i powoduje, że nie możemy oczekiwać tych samych wyników w próbie.

LOSOWA ZMIENNOŚĆ — Wiemy, że rozkład normalny ma zerową skośność i zerową kurtozę, a wykresy mają określony wygląd. Czy w związku z tym możemy oczekiwać, że w próbie będzie dokładnie tak samo? Nie. Te wymagania są zbyt idealne, aby pojawiły się w naszym świecie empirycznym. Rozkład normalny jest przecież rozkładem teoretycznym – zerowa skośność i zerowa kurtoza nie wynika z czyjegoś doświadczenia, a z precyzyjnych matematycznych obliczeń. Trzeba jednak pamiętać, że jest to wynik teoretyczny. Oczekiwania, co do tego, co pojawi się w zebranej przez badacza próbie, muszą być łagodniejsze.

Najłatwiej wytłumaczyć to sobie w następujący sposób: gdybyśmy zgromadzili wszystkie osoby (tj. przebadali całą populację) i wówczas policzyli skośność i kurtozę, to powinna ona wynosić zero - zero jest populacji. Ale próba jest tylko wycinkiem populacji i mogą trafić się różne osoby (czyli wchodzi tu losowość wyników), więc trudno liczyć na to, że skośność i kurtoza będzie równa dokładnie zero. Dlatego musimy wykazać się pewną elastycznością w oczekiwaniu, że wartości statystyk opisowych w próbie będą zero. Innymi słowy, musimy zaakceptować pewne niezerowe (choć bliskie zeru) wartości a nie żądać dokładnych zer.

ZNACZENIE WIELKOŚCI PRÓBY — Trudno jednak nie wspomnieć o wadzie tych reguł kciuka - są one sztywne, czyli niezależne od liczby przebadanych osób. A przecież nawet na chłopski rozum, nawet gdy badana zmienna ma rozkład normalny (np. inteligencja), to wzrost liczby badanych powinien powodować zbliżanie się skośności i kurtozy do tej idealnej, zerowej wartości. Podobnie jest z wykresami. To, co uchodzi w małej próbie, nie powinno przytrafi się w dużej.

REGUŁY KCIUKA — Z pomocą przychodzą wskazówki, które mówią, jaki przedział niezerowych wartości skośności i kurtozy można dopuścić jako przedział takich wartości, które jeszcze nie powodują uznania, że badany rozkład nie jest rozkładem normalnym. Nazywam je regułami kciuka - powinny sprawdzać się w większości typowych sytuacji, ale nie mają statusu twierdzenia matematycznego. Dla ścisłości, będziemy mówić o próbkowej skośności (teoretyczna wynosi 0) i próbkowej kurtozie (teoretyczna wynosi 0) oraz o empirycznych wykresach. Wszystko dlatego, aby podkreślić, że liczymy statystyki i tworzymy wykresu z udziałem próby, a nie teoretycznych wartości.

NARZĘDZIA DIAGNOSTYCZNE

- STATYSTYKI OPISOWE

- skośność — Przedział niezerowych, lecz wciąż akceptowalnych wartości próbkowej skośności to [–1, 1].

- kurtoza — Przedział niezerowych, lecz wciąż akceptowalnych wartości próbkowej kurtozy jest nieco szerszy niż dla skośności i wynosi [–2,2].

- WYKRESY

- wykres skrzynkowy (boksplot) — wykres skrzynkowy dla małej próby, N = 10, dla umiarkowanej próby, N = 30, oraz dla dużej próby, N = 1000. Wykres dla dziesięciu osób zupełnie nie przypomina wykresu skrzynkowej rozkładu normalnego, a przecież wiemy, że te dziesięć wartości pochodzi z rozkładu normalnego. Przyczyną jest losowa zmienność, która zaciera charakterystyczną strukturę tego wykresu. Dla trzydziestu wartości boksplot jest przynajmniej symetryczny, a najpiękniejszy z nich jest wówczas, gdy zbierzemy wartości od tysiąca osób.

- histogram — tutaj również pokazane są histogramy dla trzech typów prób: o bardzo małych liczebnościach, N = 10, dla umiarkowanych prób, N = 30 oraz dla prób o dużej liczebności N = 1000. Histogram rozkładu cechy, nawet jeśli wiadomo, że w populacji jest ona gaussowska, w małej próbie jest w ogólnie podobny do dzwonowej krzywej Gaussa. Cechy charakterystyczne histogramu są widoczne dopiero w dużych próbach.

- wykres kwantylowy — aby badana zmienna posiadała rozkład normalny, punkty powinny układać się na prostej. Tak dzieje się na trzecim wykresie, ale jednocześnie jest to wykres próby bardzo licznej o N = 1000 obserwacji. W mniejszym próbach musimy zrezygnować z takiego oczekiwania.

KONIECZNOŚĆ STOSOWANIA TESTÓW NORMALNOŚCI? — Narzędzia palpacyjne, takie jak powyżej, to inna oprócz formalnych testów statystycznych metoda badania normalności rozkładu zmiennej. Niestety, badacze są przyzwyczajeni do tego, że testy statystyczne to jedyna poprawna opcja. Tymczasem to po pierwsze nieprawda, jak widać na załączonym obrazku, a po drugie - testy statsytyczne same w sobie obarczone są problemami. Zwróćmy uwagę, że nigdzie nie kontrolujemy liczebności próby, posługując się mglistymi stwierdzeniami, że takie-to-a-taki test jest mocniejszy niż inny. Kierowanie się tylko i wyłącznie istotnością statystyczną testu normalności może sprawić, że badacz popełni błąd. Najlepsze rozwiązanie to łączyć obie metody - palpacyjną i formalną.

DIY - czyli zrób Diagnostykę normalności w SPSS 28. Masz niższą wersję? Nie martw się. Różnice w krokach między tą wersją SPSS a pozostałymi są chyba - nomen omen - nieistotne.

1. Zidentyfikuj zmienną, której normalność chcesz badać. Tutaj ta zmienna nazywa się banalnie - po prostu: Cecha. Następnie wybierz Analiza -> Opis statystyczny -> Eksploracja.

2. Przesuń badaną zmienną z lewego, białego okna na prawe, górne o nazwie Zmienne zależne. Dzięki temu SPSS będzie wiedzieć, którą zmienną diagnozujesz.

Klikając przycisk Statystyki, nic szczególnego nie ma do wyboru. SPSS wie, co ma wybrać. Więc pozostaw zaznaczoną opcję Statystyki opisowe i wciśnij Dalej.

4. Kliknij na drugi od góry przycisk Wykresy. Pojawi się nowe okienko. W panelu Wykresy skrzynkowe pozostaw domyślnie zaznaczoną opcję Poziomy czynnika razem. W panelu Opis odznacz Łodyga-i-liście (tym wykresem nie będziemy zajmować się) i zaznacz Histogram. Następnie, zaznacz okienko Wykresy normalności z testami. Mimo tego, że w tym poście nie zajmujemy się testami normalności, to aby uzyskać wykres kwantylowy (qqplot), musimy zaznaczyć wszystko.

Naciśnij Dalej.

5. Gdy wrócisz do głównego okienka, wybierz OK. To już wszystkie polecenia, jakie są nam potrzebne.

| PRZYDAŁ SIĘ TEN ARTYKUŁ? LUBISZ TEN BLOG? A MOŻE CHCESZ COŚ ZROBIĆ DLA MNIE? :) Właśnie prowadzę badania nad adaptacją pewnego psychologicznego kwestionariusza. Zbieram odpowiedzi od osób badanych. Ale, nie, nie chcę prosić Cię o wykonanie analiz :) Chcę poprosić Cię o wzięcie udziału i wypełnienie zestawu 49 pytań, które przygotowałam (wraz z moją współpracowniczką, Amelią). Kwestionariusz FoMO dotyczy zjawiska Lęku przed Odłączenie (Fear of missing out, FoMO), czyli lęku przed tym, że inni w tym momencie przeżywają lepsze chwile niż Ty. Skutkuje to byciem przyklejonym do smartfona, skrolowaniem Fejsbuka, sprawdzaniem Messengera, co chwilę, a dalej - poważniejszym problemami niż suchość oczu. Kwestionariusz psychologiczny musi być porządnie przebadanym narzędziem i liczę na to, żę gdy zbiorę i opracuję dane właśnie taki powstanie ze wszystkimi pożądanymi właściwościami, trafnościami, rzetelnościami i innymi homologacjami. TO CO? POMOŻESZ MI? LINK znajdziesz tutaj: KLIK |